Coded Bias: il Far West delle intelligenze artificiali

Razzismo, sessismo… Nella storia che ci portiamo dietro, in maniera più o meno consapevole, starebbe il cuore dei pregiudizi delle macchine.

“Quanto una persona deve cambiare il suo essere per funzionare all’interno di sistemi tecnologici che governano sempre di più le nostre vite?” si domanda Joy Buolamwini, una dottoranda dell’MIT nell’articolo del TIME ‘Artificial intelligence has a problem with gender and racial bias. Here’s how to solve it’. La risposta? Molto poco, se sei un uomo bianco. Molto, se sei una donna. Ancora di più, se sei una donna nera.

La demistificazione della neutralità delle intelligenze artificiali è alla base di Coded Bias, documentario diretto da Shalini Kantayya presentato quest’anno con successo al Sundance Film Festival e allo Human Rights Film Festival. Kantayya è sempre stata interessata alle nuove tecnologie, rappresentate nei suoi lavori come delle forze rivoluzionarie e salvatrici, spesso come soluzioni alla scarsità delle risorse sulla Terra. Infatti, in ‘Catching the Sun’, prodotto da Leonardo DiCaprio, la regista si è concentrata sull’impatto e lo sviluppo dell’energia solare, tema centrale anche in ‘Power To The People’, l’ultimo episodio della serie National Geographic Breakthrough.

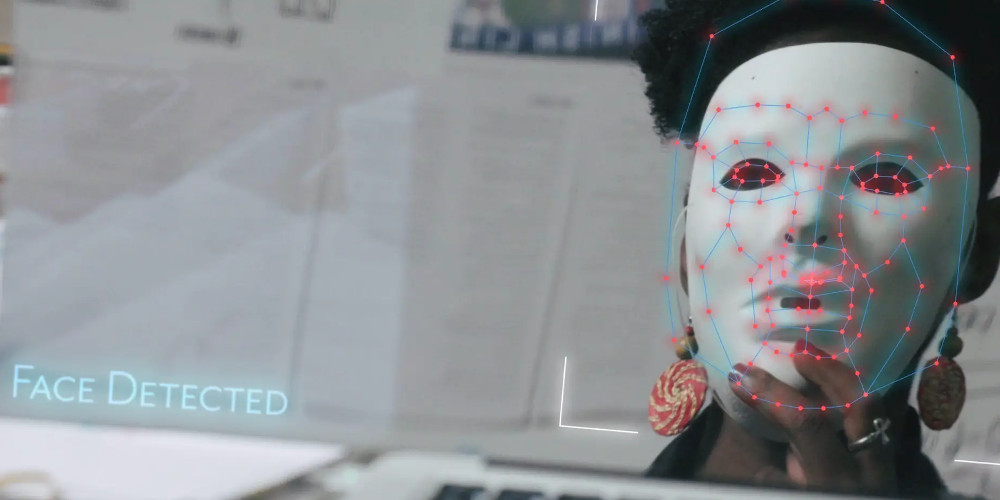

La visione della tecnologia si fa però più critica in Coded Bias. A dare il via al documentario è la scoperta di Buolamwini riguardante l’incapacità di vari software di riconoscimento facciale di individuale il suo volto. “Non hanno funzionato fino a quando non ho messo una maschera bianca. Alterare me stessa per adattarmi alle norme vigenti – in questo caso rappresentate meglio da una maschera bianca che dalla mia vera faccia – mi ha fatto capire l’impatto dell’esclusione sopraelevata, un termine che ho coniato per descrivere il costo dei sistemi che non prendono in considerazione la diversità dell’umanità”.

Sebbene il margine di errore nel riconoscimento fosse solo dell’1% per gli uomini dalla pelle chiara, questa percentuale saliva fino al 35% nel caso di donne dalla pelle scura. Se anche volti noti come quelli di Serena Williams, Michelle Obama e Oprah Winfrey non venivano riconosciuti appropriatamente dai sistemi, che possibilità avevano le persone comuni di essere correttamente identificate?

Questa scoperta ha portato Buolamwini a porsi una serie di domande scomode riguardo l’uso dei big data, la neutralità delle nuove tecnologie, il ruolo delle piccole e grandi corporazioni nella riproduzione delle discriminazioni razziali e di genere nella tecnologia. Da ricercatrice che si sentiva distaccata dai problemi del mondo ogni volta che si immergeva nel codice, Buolamwini si è ritrovata faccia a faccia con i pregiudizi della ‘vita reale’ proprio grazie a quello stesso codice da cui si sentiva protetta e schermata. Kantayya segue così il percorso della dottoranda che si trasforma in agente di cambiamento, fondando l’Algorithmic Justice League e la Safe Face Pledge per prevenire l’(ab)uso delle tecnologie di riconoscimento e la discriminazione attraverso il ricorso a intelligenze artificiali.

Contributi di alto livello

Come si trova giustizia in un mondo dove non si sa bene come funzionano gli algoritmi alla sua base? Quanto è veramente democratico l’uso sregolato di sistemi di identificazione facciale? Da dove nascono i pregiudizi nelle macchine? Questi sono solo alcuni degli interrogativi a cui il documentario si propone di rispondere, alternando il percorso di Buolamwini – che la porterà a discutere la sua tesi direttamente alla Casa Bianca – con le ricerche di alcuni esperti del settore. Tra questi, troviamo Meredith Broussard, autrice di ‘Artificial Unintelligence: How Computers Misunderstand the World’; Virginia Eubanks scrittrice di ‘Automating Inequality’; Ravi Naik, vincitore del premio Avvocato dell’Anno per i Diritti Umani, che tra le sue cause annovera quella contro Cambridge Analytica; la giornalista e ricercatrice Zeynep Tufekci; la matematica Cathy O’Neil, autrice di ‘Weapon of Math Destruction’; Safiya Umoja Noble, insegnante all’UCLA esperta in sistemi di ricerca e pregiudizi, ed infine Silkie Carlo, direttrice del Big Brother Watch UK.

Lo scrittore ed attivista James Baldwin affermò che “la grande forza della storia viene dal fatto che ce la portiamo con noi, siamo inconsciamente controllati da essa in molti modi, e la storia è letteralmente presente in tutto quello che facciamo”. Nella storia che ci portiamo dietro, in maniera più o meno consapevole, starebbe il cuore dei pregiudizi delle macchine.

Il peso del passato

Coded Bias non è un film sci-fi in cui gli algoritmi impazziscono e diventano cattivi. Le AI sono il nostro futuro, ma sono programmate su dati che riflettono il nostro passato e il nostro presente, ancora intriso di disuguaglianze di genere e di razza. Come pensiamo di migliorare il futuro se nelle rappresentazioni date in pasto alle macchine riflettiamo una situazione disparitaria? Tra i casi più famosi, viene citato il progetto sperimentale di Amazon, che vedeva l’uso di machine learning per l’assunzione dei propri dipendenti. L’AI escludeva dalla candidatura le donne, in quanto aveva osservato i CV presentati alla società nei precedenti dieci anni e aveva così imparato “da solo” che i curriculum degli uomini erano preferibili.

“La matematica viene nominata come scudo per nascondere pratiche corrotte. Gli algoritmi usano informazioni storiche per creare predizioni sul futuro – dichiara O’Neil – funzionano come un sistema di punteggi che segnala la probabilità di quello che stai per fare.” Ma i dati attuali, usati alla base dei processi di apprendimento delle macchine, dipendono in parte da fattori strutturali di un sistema che ha sempre privilegiato una determinata parte della popolazione. Si ripeterà così una discriminazione strutturale che apparirà ancora più difficile da contestare e combattere in quanto più subdola e invisibile.

Diversi studi hanno dimostrato come essere di colore e/o parte di un gruppo etnico minoritario abbia portato a sostanziali disuguaglianze nel calcolo del rischio in caso di prestiti, in particolare mutui per la casa, anche quando a compiere questi calcoli erano delle AI. Queste differenze sono state registrate anche a livello di genere. Il caso più noto è quello che ha visto al centro della polemica i limiti di spesa offerti dalla Apple Card: decisamente più alti quelli proposti agli uomini in comparazione alle donne.

Lo stesso Steve Woziak, co-fondatore della Apple, e l’imprenditore David Heinemeier Hansson avevano denunciato l’enorme disparità rapportando il loro limite con quello delle moglie, con cui condividevano quasi la stessa situazione finanziaria.

Dove si gioca il futuro dei diritti umani

Il documentario propone diversi esempi concreti di discriminazioni effettuate da machine learning, presenta i risultati degli studi di Buolamwini e la sua battaglia contro i colossi dell’high tech. Guarda al mondo delle machine learning e all’uso di software di riconoscimento facciali come un nuovo far west, dove tutto è permesso perché il vuoto legislativo è ancora ampio; perché le strutture di potere continuano a riflettersi nella tecnologia a causa di una rappresentazione erronea dei dati, dei pregiudizi interni ai programmatori che, anche senza volerlo, riflettono il loro mondo: bianco, maschile ed eterosessuale. Quello che vediamo non è un futuro di cambiamento, ma l’eterno ritorno di uno scomodo passato.

Coded Bias fa di tutto per rendere il suo linguaggio comprensibile, ma sebbene gli argomenti diventino facilmente accessibili al pubblico, star dietro a tutti gli esempi e ai salti tematici può essere alienante per lo spettatore. Nonostante ciò, è un prodotto interessante che ci mostra dove si giocherà il futuro dei diritti umani. Grazie alle proteste che infiammano gli Stati Uniti dopo l’omicidio di George Floyd, il documentario sembra essere arrivato nel momento migliore per essere ascoltato. Amazon ha vietato alla polizia l’uso di Rekognition, la sua tecnologia per il riconoscimento facciale. Una posizione simile era stata presa da IBM che ha dichiarato: “IBM si oppone e non condona gli usi di nessuna tecnologia, inclusi i software di riconoscimento facciale offerti da altri venditori, per la sorveglianza di massa, la profilazione razziale, violazioni dei diritti umani e della libertà.” Ad Amazon e IBM, si è aggiunto anche Google.

Sebbene alcune battaglie sembrano per ora vinte, la strada verso un uso trasparente ed egualitario dei dati è ancora lunga da percorrere. L’importante è continuare con determinazione questo viaggio.